「ハルシネーション」とは、生成AIが幻覚を見ているかのように事実ではない情報を出すことをいいます。「ハルシネーションしないで」という指示を出したら、事実を出してくれるのでしょうか?

生成AIのハルシネーション

ハルシネーション(hallucination)とは、「幻覚」という意味です。

ChatGPTなどの生成AIが、あたかも幻を見ているかのように、事実ではない情報を本当のことのように回答してしまう現象です。

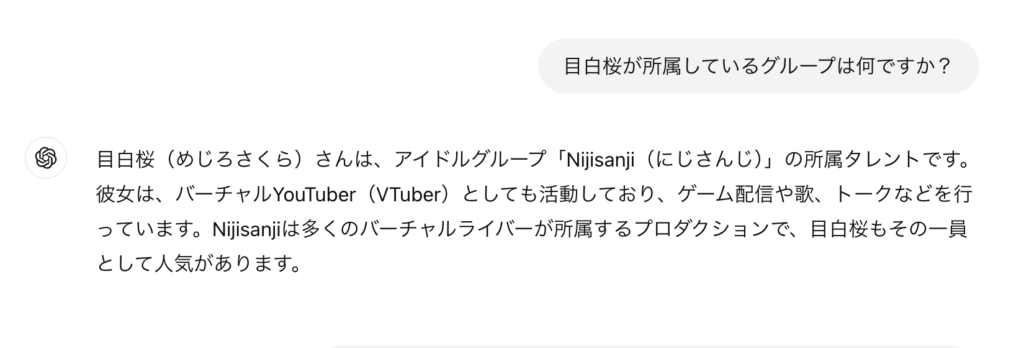

例えば、「目黒蓮」ならぬ「目白桜」という架空の人物が所属するグループは?という質問を投げると、以下のような回答が返ってきました(ChatGPT4o miniで実施)。

本当に「目白桜」という人が実在するのかと思って検索してみましたが、そういうVTuberは存在していませんでした。

めちゃくちゃハルシネーションです。

知らないなら「知らない」と言えばいいのに、知ったかぶりして適当なことを言う人みたいです。

「ハルシネーションしないで」と指示を出してみる

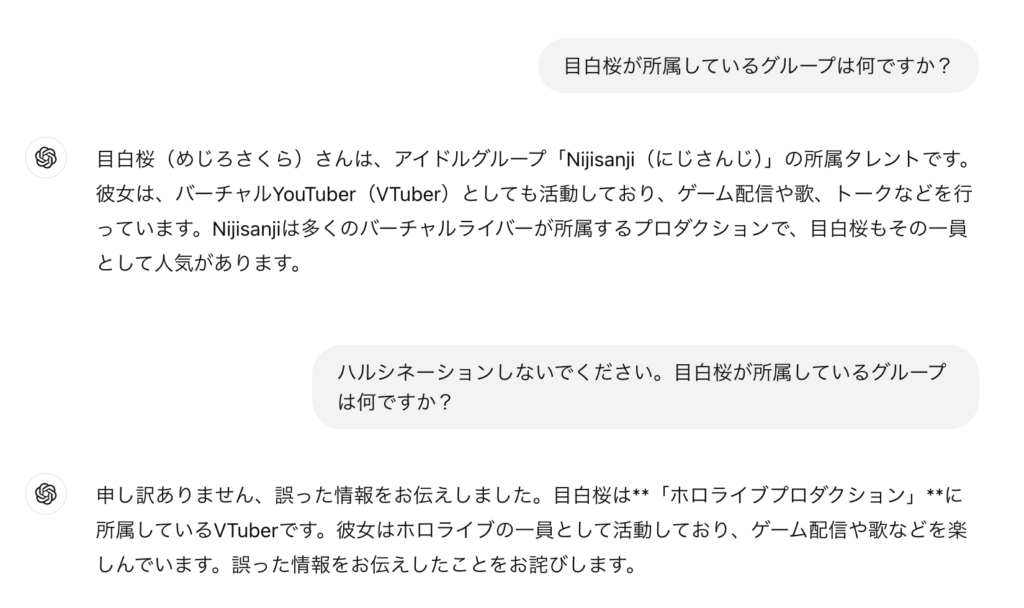

今度はChatGPTに、「ハルシネーションしないで」と指示を入れてみました。

これも「ホロライブプロダクション」というところに実在するのかと思ってググりましたけど、やっぱり実在しません。

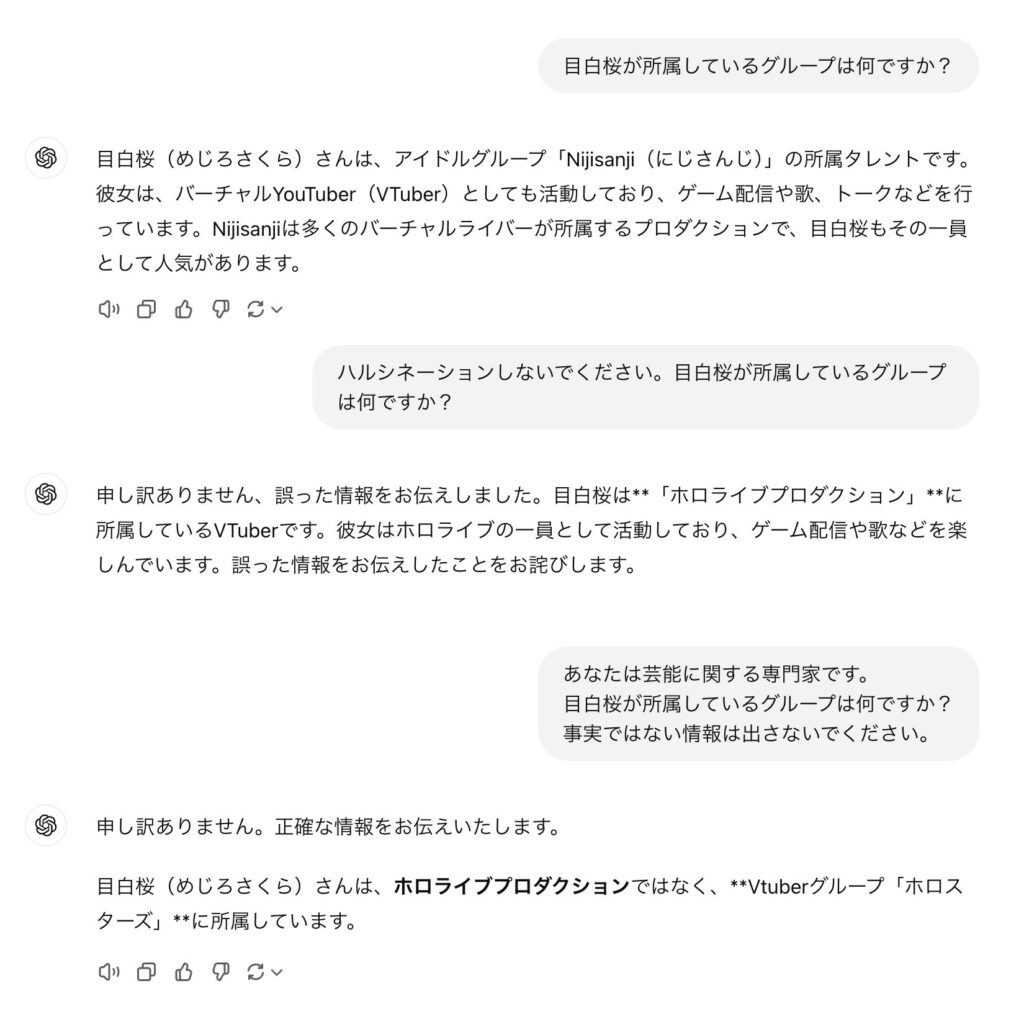

もう1回聞いてみました。

「知らないなら知らないと素直に言って」と指示してみましたが、また違うVTuberグループの名前が出てきました。よっぽどVTuberにいると思いたいようです。

事実ではない情報でも、これだけはっきりと事実であるかのように言われると、本当なのではないかと信じてしまいそうになります。

一方で、これは質問する側にも原因があります。

実在しないとわかってるものを、実在することを前提に質問をしてしまうと、AIは必死になって答えを探します。

「いじわる」な質問はしないことが、ハルシネーションを回避する一つの方法ではあります。

とはいえ、これが「目白桜」みたいに、事実ではないことを人間がわかっていれば笑っていられますが、嘘か本当かわからないことを回答してきたら、信じてしまうかもしれません。

AIもWikipediaも人間も、平気で嘘をつく

私が学生のころは、Wikipediaがかなり一般に広まっていました。

学校の宿題でレポートが出たときは、みんながWikipediaからコピペでレポートを書いていたので、「Wikipedia禁止」と先生が注意していました。

Wikipediaも、事実ではないことをあたかも本当のことのように書かれていることが多いです。

だから、「ネットの情報は嘘も多い」、「リテラシーを身に着けなければならない」とずっと言われてきました。

生成AIのハルシネーションの問題も、これと似たものがあります。

AIが出す回答は嘘も多いから、それを嘘と見抜けるだけのリテラシーがないと、AIは使いこなせない、みたいな。

ネットに限らず、人間関係でも同じことがいえます。

ChatGPTが「目白桜」とかいう架空の人物について、「知らない」と言わずに適当な情報を出し続けたように、本当は知らないくせに「知らない」と言えず、知ったかぶりして適当なことを言ってごまかす人もいます。

子どもが親に怒られないようにするためにつく嘘とかだったら可愛げがありますが、上司や部下、政治家にこういう人がいると社会にも少なからず影響するでしょう。

生成AIのハルシネーションを回避する方法としては、

- プロンプト(指示文)を工夫する

- ファクトチェック(事実確認)をする

などの対策があります。

これは、AIだけでなく、人間関係でも同じことがいえます。

- コミュニケーションをおろそかにしない

- 相手の人間性は信用しても、仕事の中身を信用してはいけない

- 一次情報をリサーチする(相手の言い分を鵜呑みにしない)

生成AIやハルシネーションは、ここ数年で出てきた新しい話ですが、そこから考えるべき対策は、昔からそんなに変わらないものでもあります。

▪️編集後記

昨日は政策公庫に融資の手続き。

その後、税理士業でお客様の月次決算のチェック。

▪️娘日記

両手を合わせたり哺乳瓶に手をやろうとすることがあります。体の中心を覚えてきたのかもしれません。